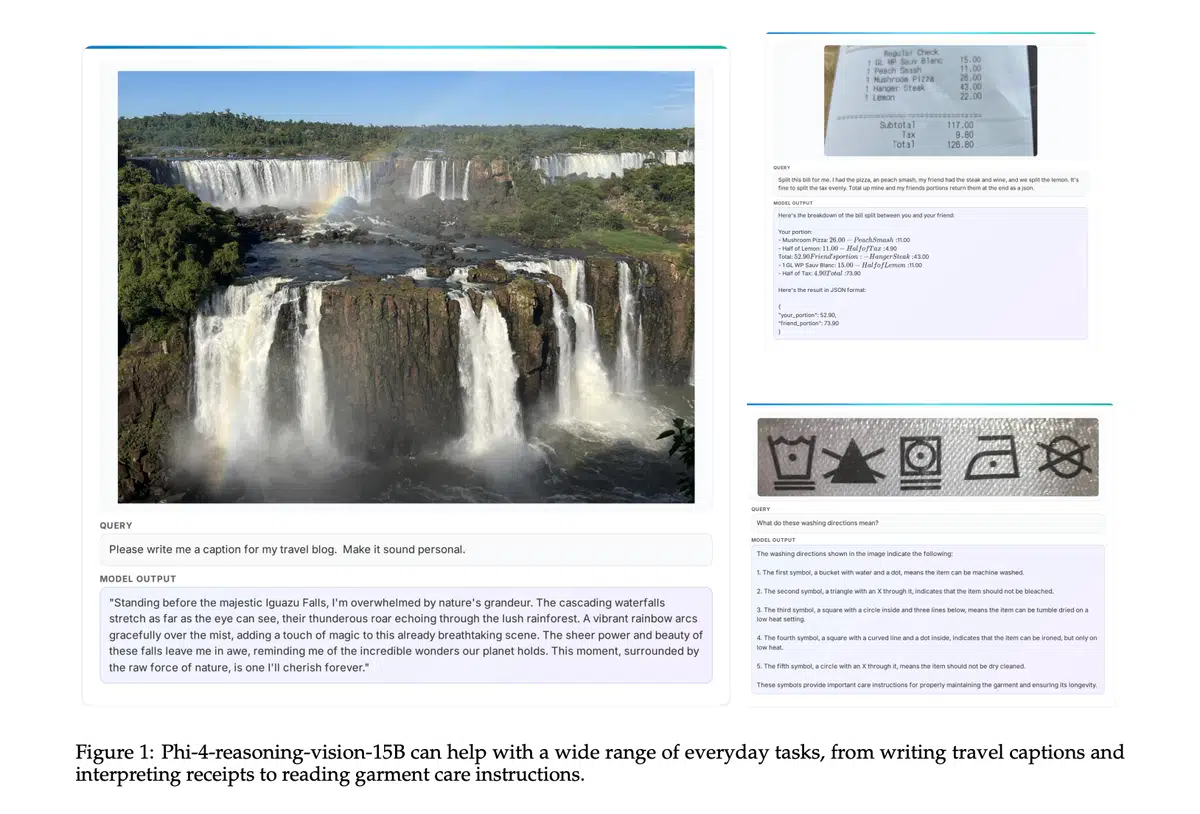

MicrosoftPhi-4SigLIP-2GUI

•5 阅读•1分钟•前沿

Anthropic的Claude在两周内发现Firefox 22个漏洞,14例高危敲响安全警钟

生成式AIClaudeAnthropicFirefox安全漏洞

•5 阅读•1分钟•前沿

OpenAI发布GPT‑5.4 Pro和Thinking版,千兆级上下文与效率再创新高

OpenAIGPT-5.4Tool Search千兆级上下文

•16 阅读•1分钟•前沿

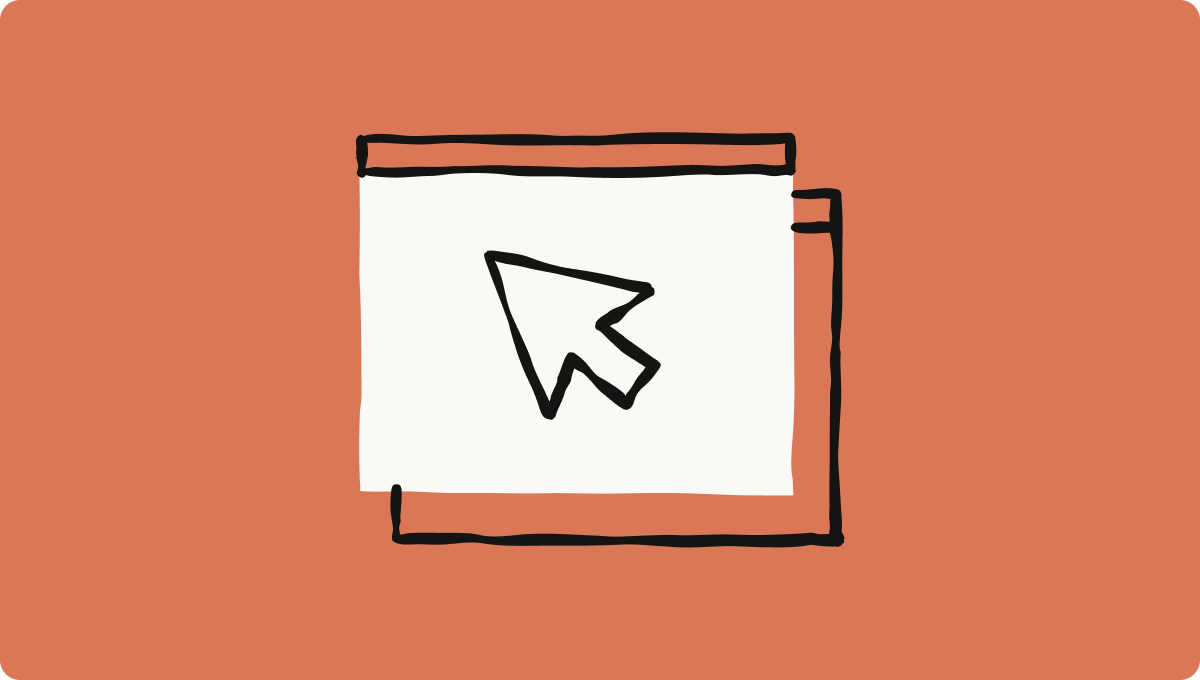

Olmo Hybrid 7B发布:混合架构实现双倍预训练效率,挑战传统Transformer

开源OlmoGDNMamba

•13 阅读•1分钟•前沿

OpenAI发布GPT‑5.4 Thinking系统卡 强化网络安全防护能力

网络安全OpenAI安全GPT-5.4

•8 阅读•1分钟•前沿

OpenAI推出GPT‑5.4,打造万兆上下文与原生电脑使用的专业级前沿模型

OpenAILLMAPIAgentGPT-5.4

•12 阅读•1分钟•前沿

OpenAI发布CoT‑Control评估:前沿推理模型难以操控思考链,监控可信度提升

OpenAIGPT-5CoT-Control

•8 阅读•1分钟•前沿

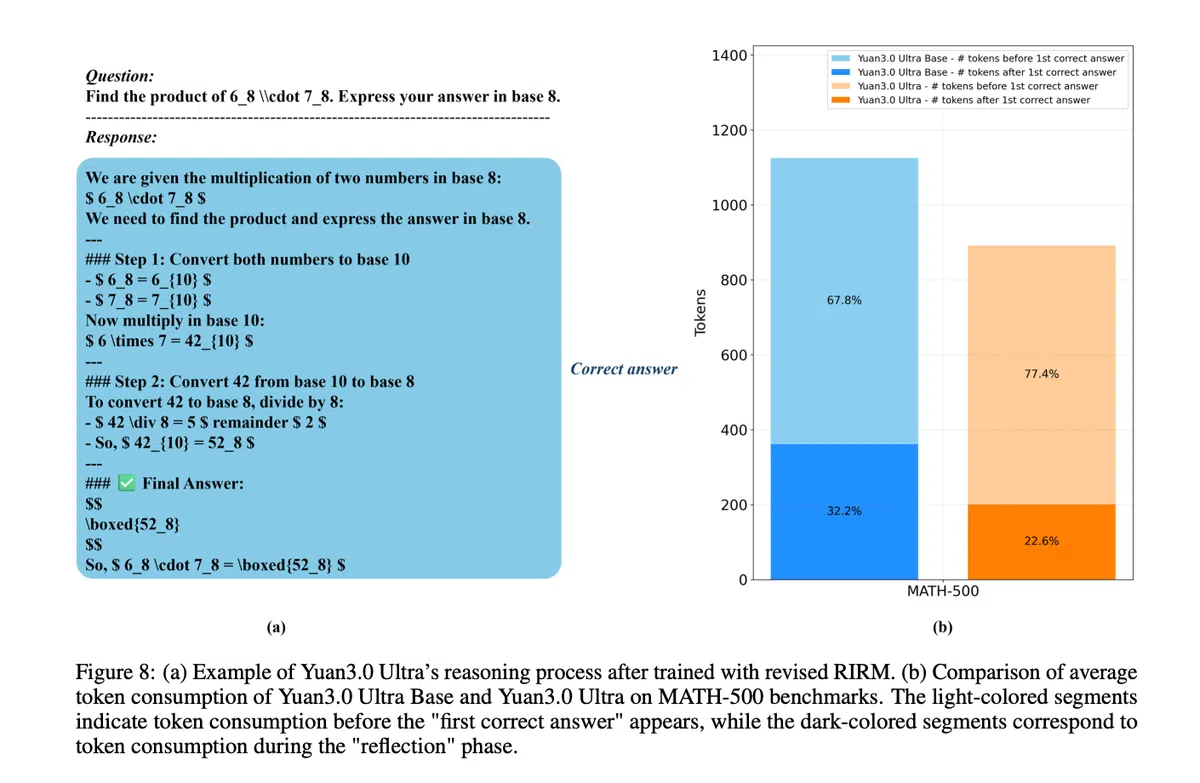

YuanLab推出Yuan 3.0 Ultra,实现千亿参数MoE模型参数削减33%并提升训练效率49%

LLMMoEYuanLabYuan 3.0 Ultra

•12 阅读•1分钟•前沿

阿里巴巴发布Qwen 3.5系列 引领开源大模型新范式

开源大模型MoE阿里巴巴Qwen 3.5

•19 阅读•1分钟•前沿

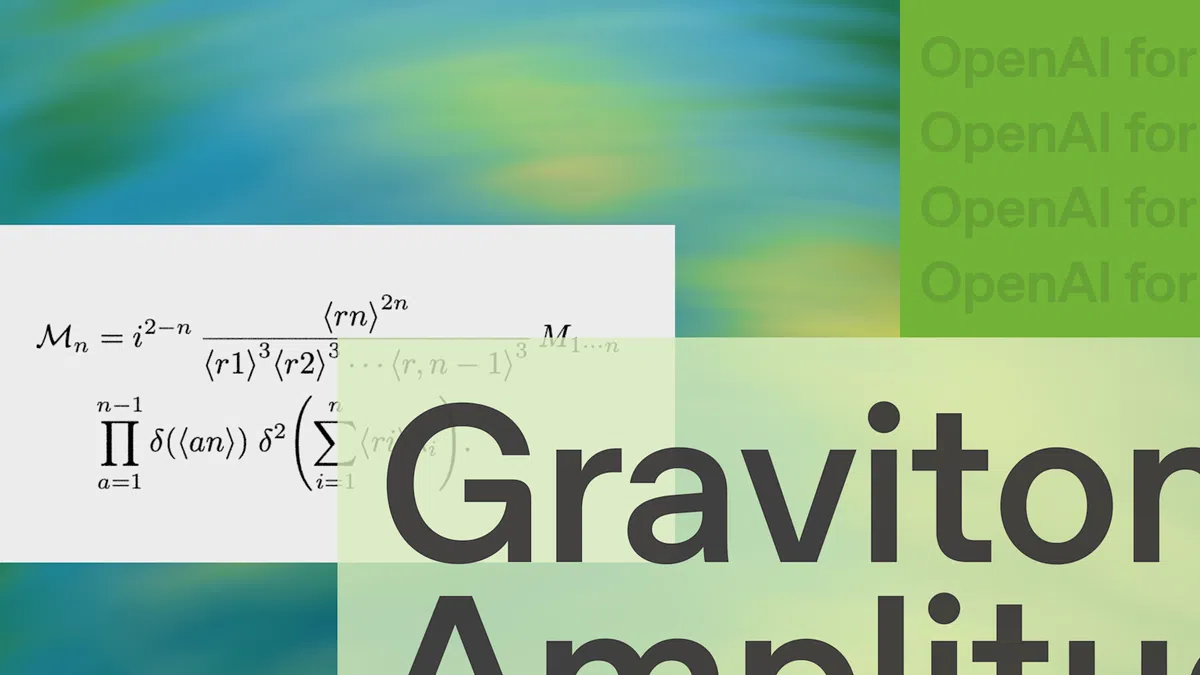

OpenAI携手学者证实单负号引力子振幅非零,量子引力实现新突破

OpenAIGPT-5.2Graviton单负号振幅

•8 阅读•1分钟•前沿

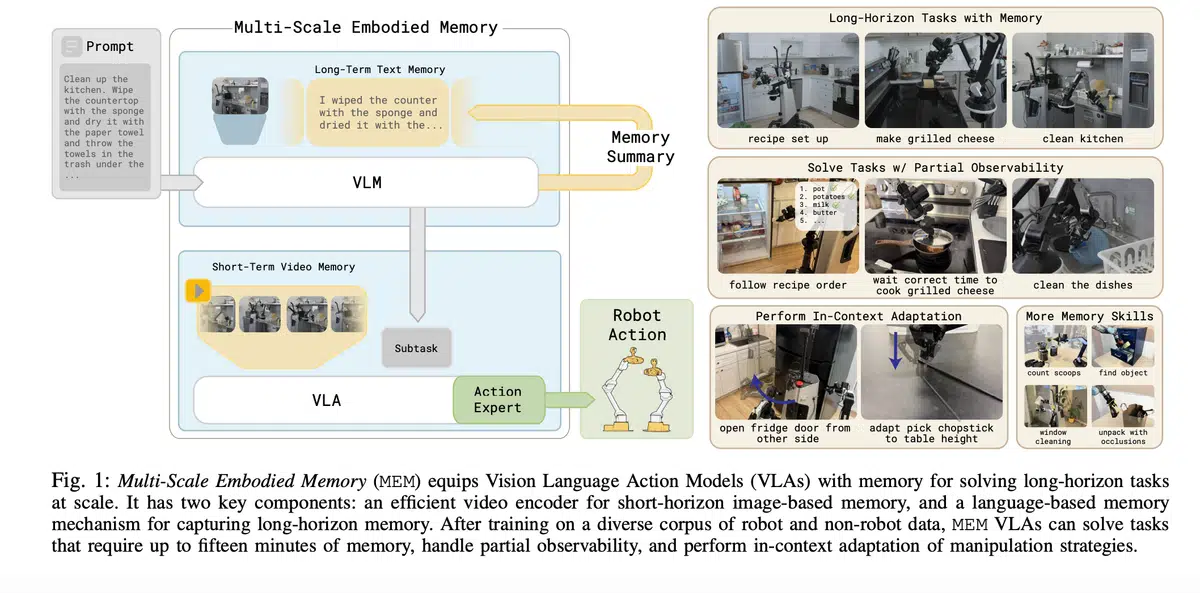

Physical Intelligence团队推出多尺度记忆系统MEM,让Gemma 3‑4B机器人模型拥有15分钟上下文

Physical IntelligenceGemma 3-4BMEMVLA

•18 阅读•1分钟•前沿

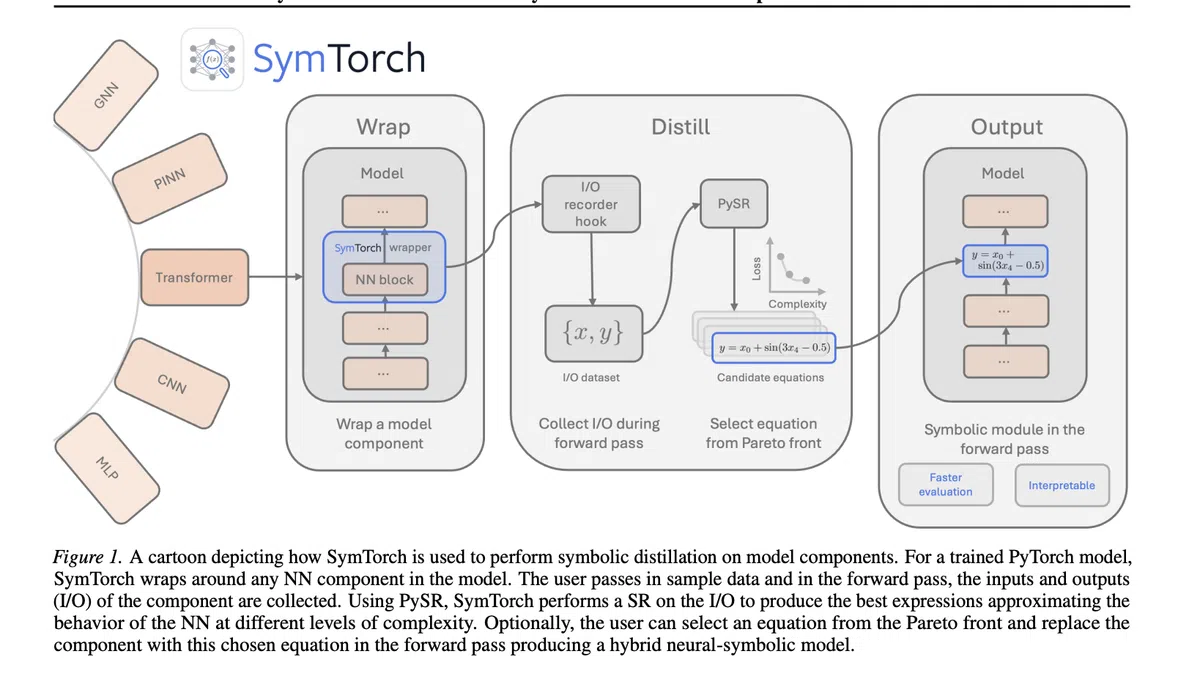

SymTorch让深度模型转化为可解释方程,开启AI可解释性新篇章

LLMUniversity of CambridgeSymTorchSymbolic Regression

•22 阅读•1分钟•前沿

OpenAI推出GPT‑5.3 Instant 取消“冷静”提示提升对话体验

ChatGPTOpenAIGPT-5.3

•20 阅读•1分钟•前沿

Photoroom 24小时完成文本生成图像模型训练 展示高效扩散新配方

生成式AINVIDIAPhotoroomDiffusion

•14 阅读•1分钟•前沿

Google发布Gemini 3.1 Flash‑Lite 加速高频工作负载并大幅降低成本

GoogleGeminiLLMVertex AIFlash‑Lite

•17 阅读•1分钟•前沿

Google发布Gemini 3.1 Flash‑Lite 兼具极速与低成本 助力高频开发者工作负载

GoogleLLMVertex AIGemini 3.1 Flash‑Lite

•17 阅读•1分钟•前沿

中国实验室发布Qwen 3.5、GLM‑5与MiniMax 2.5 加速开源大模型赛道

百度GLM-5Qwen 3.5智谱AIMiniMaxAI

•15 阅读•1分钟•前沿

Apple推出搭载M5芯片的MacBook Air与Pro,AI运算提升四倍

AppleMacBook ProM5MacBook Air

•10 阅读•1分钟•前沿

OpenAI发布GPT‑5.3 Instant提升对话流畅度与信息准确性

OpenAI生成式AILLMGPT‑5.3

•13 阅读•1分钟•前沿

OpenAI发布GPT‑5.3 Instant系统卡 提升对话速度与检索质量

OpenAILLMGPT-5.3

•11 阅读•1分钟•前沿