MIT递归语言模型突破:破解长文本“上下文腐化”瓶颈

•5 次浏览•3分钟•前沿

大模型递归语言模型上下文腐化MIT提示工程

Jesus Rodriguez••5 阅读•3分钟•前沿

背景与挑战

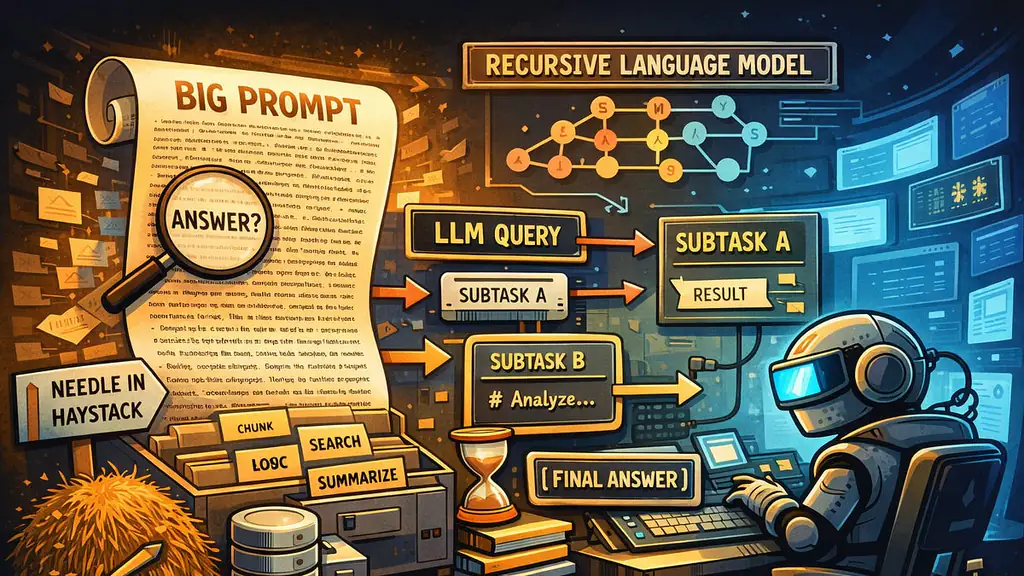

在使用前沿大模型进行文档阅读或问答时,常见的做法是把整篇长文直接塞进提示(prompt),期望模型在一次注意力计算中完整理解。然而,MIT CSAIL最新论文《Recursive Language Models》指出,这种“填满上下文”的做法会导致上下文腐化(context rot)——模型的有效工作集被无限放大,注意力被稀释,输出质量随长度呈指数衰减。

“模型并没有真正‘阅读’,而是像在图书馆里一次打开所有教材,结果只剩下噪声。” — 论文作者

递归语言模型的核心思路

递归语言模型(RLM)从系统层面重新审视长文本处理流程,核心理念可概括为三点:

- 层级拆分:将超长文本递归划分为若干上下文块,每块大小保持在模型最优注意力范围内。

- 块间复用:对每个块进行独立推理后,利用轻量级汇总模块将块级结果合并,形成全局答案。

- 动态记忆:在递归过程中维护一个紧凑的记忆向量,避免重复计算,提升效率。

这种设计让模型的计算复杂度从原来的 (O(N^2)) 降至近似 (O(N \log N)),同时保持或提升推理准确度。

实验结果与行业意义

MIT 团队在多项长文检索、法律文档分析和代码审查任务上对比了传统大模型与 RLM,得到以下关键数据:

- 准确率提升:在 50,000 字的法律文档问答中,RLM 的 F1 分数从 0.68 提升至 0.82。

- 推理时延下降:相同硬件下,RLM 的平均响应时间比传统模型快 35%。

- 显存占用下降:递归处理将显存需求从 32 GB 降至约 12 GB,降低了部署门槛。

这些结果表明,长文本场景不再只能依赖“更大上下文窗口”来解决,而是可以通过 算法结构创新 来突破硬件限制。对企业而言,这意味着在内部文档检索、金融报告分析等垂直领域可以用更小的模型实现更高的性能,显著降低成本。

展望

递归语言模型的提出为 提示工程 注入了全新思路,也为 开源社区 提供了可实现的方向。后续研究可能聚焦于:

- 将 RLM 与检索增强生成(RAG)结合,形成端到端的长文检索‑生成管线;

- 在多模态(文本+图像)长序列任务中扩展递归框架;

- 开源实现与基准套件,帮助开发者快速落地。

如果行业能够快速采用这一范式,AI 在知识密集型工作中的实用性将迎来一次质的飞跃。

本文是对第三方新闻源的主观解读。消息可能出现过时、不准确、歧义或错误的地方,仅供参考使用。点击此处查看消息源。